인텔은 미국 샌프란시스코 시내에서 AI(인공지능) 전략에 관한 기자 회견 "Intel AI Day"를 갖고 머신 러닝, 딥-러닝 등의 새로운 컴퓨팅 모델을 활용해 AI를 실현하는 반도체, 소프트웨어에 관한 발표를 진행했다.

인텔이 IA 전용 솔루션에 주력한다. 앞으로 제품 확충

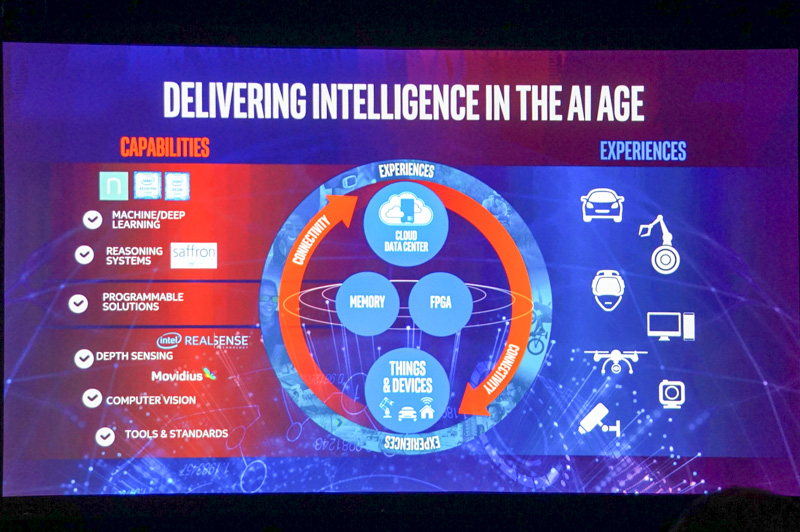

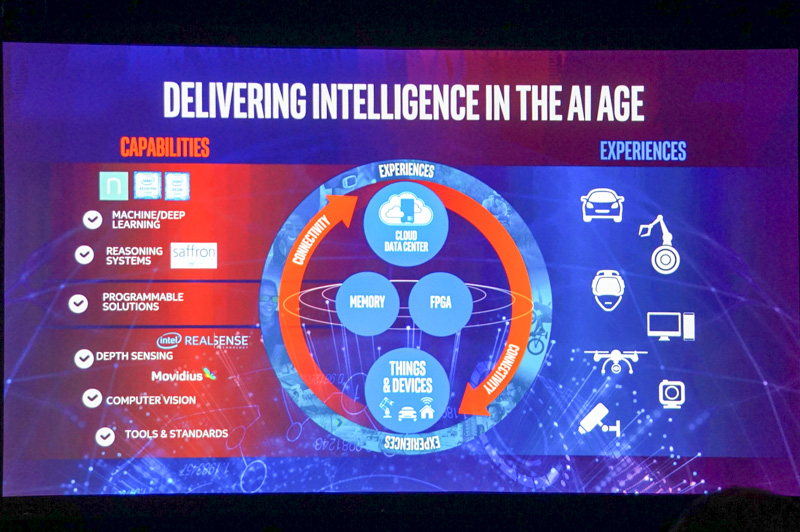

기자 회견 모두 발언에서 인사에 선 Intel CEO의 브라이언 크르자니크는 "현재 수십 억의 스마트 기기가 인터넷에 접속되고 있으며 앞으로도 증가한다. AI는 그러한 스마트 커넥티비티 디바이스에 있어서 매우 중요한 기술이다. 인텔은 그런 AI를 위한 완전한 솔루션을 한방에 제공하고 있으며 향후 이를 확대한다" 며 다양한 차원에서 AI용 반도체와 소프트웨어 등을 제공하고 IoT 기기용 반도체(Atom 프로세서 등), 5G를 위한 통신 솔루션, 클라우드 측에서 머신-러닝이나 딥-러닝에 이용되는 반도체(Xeon, Xeon Phi 등)의 클라이언트, 통신 서버 등 IoT 생태계 전체에 반도체를 제공할 수 있는 것이 강점이라고 강조했다.

AI용 반도체 하면 일반적으로는 딥 러닝용 연산 등에 이용되고 있는 GPU 등의 범용 프로세서가 잘 알려져 있지만 실제로는 딥-러닝은 머신 러닝의 한가지 방법이며 CPU를 이용한 머신 러닝도 비슷하게 중요한 요소다. CPU, 특히 클라우드 서버는 사실상 IA(Intel Architecture, 이른바 x86) 중 택일로 머신 러닝이라는 큰 매듭으로 보면 인텔은 머신 러닝 시장에서 강한 존재감을 갖고 있다.

크르자니크는 "딥 러닝은 물론 중요하지만 스몰 세트다. AI는 확장성이 있는 것으로 GPU 만이 성능을 결정하는 것이 아니다" 며 인텔 아키텍처의 AI 중요성을 강조하면서 향후 인텔이 지금보다 강한 AI를 약속하겠다고 강조했다. 크르자니크는 지난 1년간 Saffron Technology, Movidius, Nervana Systems 등의 AI 관련 기술을 가진 기업을 인수하면서 AI 관련 포트폴리오를 늘려 왔다고 밝혔다.

그 위에서 Nervana System CEO를 무대로 부르며 인텔과 Nervana의 향후 전략에 대해서 설명했다. 이 가운데 크르자니크는 Nervana의 자산과 인텔의 기존 자산을 통합하고 앞으로 AI용 반도체와 소프트웨어 등의 플랫폼을 "Intel Nervana platform"으로 전개하겠다고 밝혔다.

크르자니크는 "중요한 것은 신뢰성이다. 인텔은 신뢰성 높은 AI 플랫폼을 향후로도 제공한다" 며 향후 인텔이 AI를 중요한 비즈니스의 하나로 파악하여 힘을 넣겠다는 방향성을 강조했다.

2020년까지 현재보다 100배 웃도는 딥 러닝 솔루션 투입

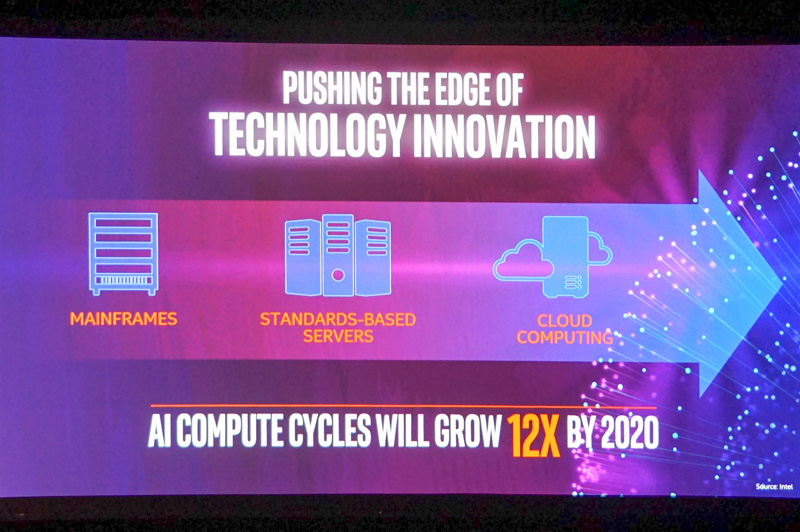

크르자니크에 이어 등단한 것은 인텔의 다이앤 브라이언트. 그는 "2020년에는 AI에 필요한 컴퓨팅 파워는 지금보다 12배로 확대할 것으로 예상된다" 며 AI에 필요한 연산 능력이 늘어나기 때문에 이에 대처할 필요가 있다고 밝혔다.

여기서 인텔의 새로운 AI를 위한 전략 중 하나로 구글과의 협업에 대해서 발표했다. Google은 AlphaGo와 DeepMind 같은 AI을 개발하고 딥 러닝 프레임워크에서 톱 쉐어 TensorFlow를 제공하는 등 AI 세계에서 선두를 달리고 있다. 브라이언트가 불러 등단한 구글의 엔터프라이즈 담당 수석 부사장 다이앤 그린은 "인텔은 그 동안 서버 개발 등에 협력했지만 차세대 개발도 함께 한다. TensorFlow를 IA에 최적화 하고 딥 러닝 학습 등에 대해서도 최적화한다. 또 IoT 보안 확보에서도 협업하겠다" 며 인텔과 AI 개발 환경의 확충 등에서 협력하겠다고 밝혔다.

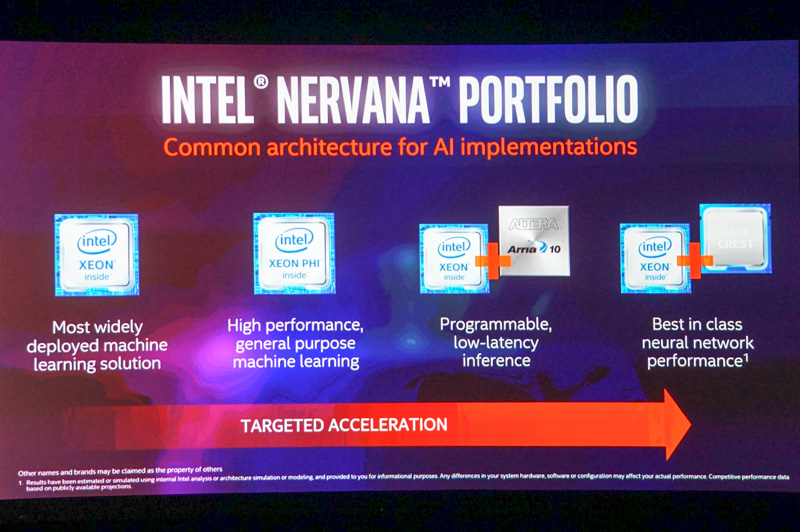

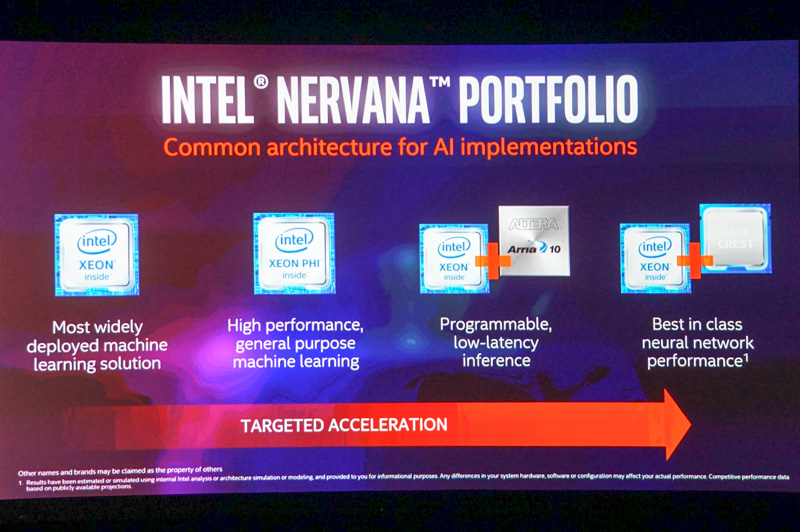

그는 "2016년 마지막 시점으로 예측하면 94%의 AI 서버가 GPU가 없는 IA 서버다. 앞으로도 AI용 IA 솔루션을 점차 강화하고 싶다"며 인텔이 제공하고 있는 IA용 반도체 제품을 향후로도 적극적으로 확충할 것이라고 밝혔다. 그런 AI용 인텔의 제품으로 그는 Xeon E5, Xeon Phi, Xeon+FPGA, 또 이번에 새로 발표된 딥 러닝용 액셀러레이터 4가지를 꼽았다.

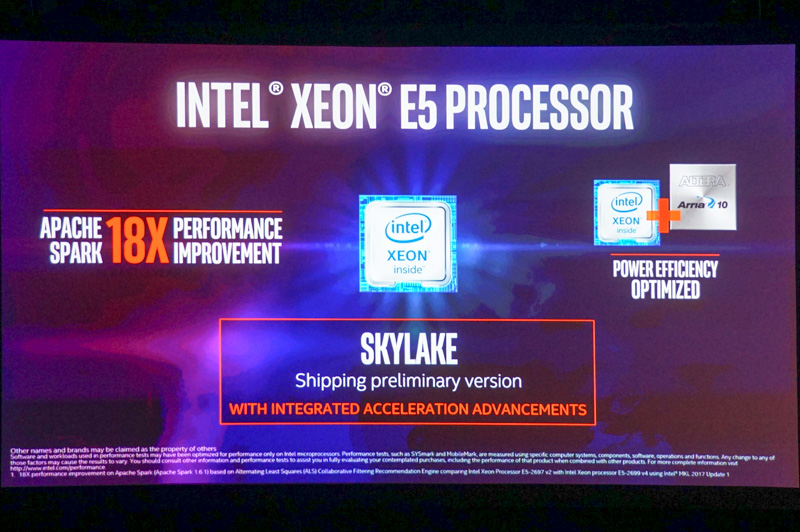

Xeon E5 등 Xeon프로세서는 현재 데이터 센터에서 이용되는 클라우드 서버의 대다수에서 채용되고 있는 CPU다. 그는 그 Xeon E5의 차세대 버전으로 계획하고 있는 "Skylake-EP"를 언급하면서 초기 개발 버전의 출하를 시작했다고 밝혔다. AVX512 등의 새로운 명령 세트, 부동 소수점 연산 기능의 확장 등으로 성능이 향상됐으며 Apache Spark를 이용하면 성능은 18배나 된다고 한다. 또한 제품 버전은 2017년 중반 출하를 상정하고 있다고 설명했다.

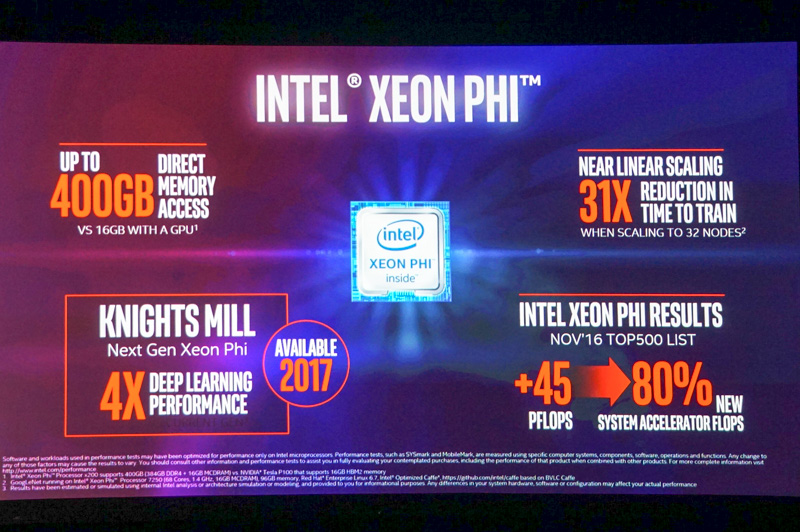

Xeon Phi에 대해서는 올해(2016년) 발표한 나이츠 랜딩(Knights Landing)을 설명하며 "Knights Landing으로 현 시점에서 최대 32노드까지 연결이 가능해 학습 성능은 31배나 된다. 또, 메모리는 GPU에 16GB까지 밖에 이용할 수 없지만 Knights Landing은 최대 400GB까지 이용할 수 있다" 며 GPU에 비해 스케일 아웃으로 불리는 복수의 노드를 연결하여 병렬로 실행함으로써 더 높은 성능을 실현할 수 있다고 강조했다. 또 8월에 열린 IDF에서 발표한 차세대 제품인 나이츠 밀(Knights Mill)에 대해서도 설명하며 배정밀도, 단정밀도에 반정밀도 부동 소수점 연산 지원 등으로 현행 Kights Landing에 비해 4배의 딥 러닝 성능을 실현하겠다고 강조했다.

이어 그는 인텔이 인수한 Nervana가 개발한 딥 러닝용 엑셀러레이터 칩으로 "LAKE CREST"(개발 코드 네임)을 발표하면서 2017년 상반기에 투입하겠다고 밝혔다. Xeon 프로세서에 그 딥 러닝용 액셀러레이터 칩을 통합한 "Knights Crest"(나이츠 크레스트, 개발 코드 네임) 계획도 밝혔다(투입 시기는 발표가 없었다). 그는 "인텔은 딥 러닝에 걸리는 시간을 현재 가장 빠른 GPU와 비교해 100분의 1로 가능하게 하는 솔루션을 제공한다" 며 인텔이 지금까지 딥 러닝에서 최고라고 불리는 엔비디아 GPU에 대한 도전장을 내밀었다.